SEO, indicizzazione dei contenuti e posizionamento sui motori di ricerca

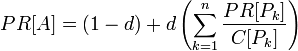

Google è in grado di posizionare un sito internet sulla base di un complesso algoritmo che è costantemente aggiornato, in modo tale che il posizionamento della pagina dipenda dall’importanza data a certi parametri e contenuti al momento della pubblicazione del sito (si veda anche l’articolo sul SEO: Cosa significa fare ottimizzazione di un sito web per i motori di ricerca?). A ogni pagina è associato un PageRank (PR), ovvero un valore numerico compreso fra 1 e 10, calcolato sulla base di una formula ben precisa, che valuta l’importanza della pagina Web visitata sulla base del quantitativo di link che vi puntano. La differenza rispetto al concetto di backlinking (o inbound linking), ovvero l’insieme dei collegamenti in ingresso ad una determinata pagina Web, sta nel fatto che l’algoritmo valuta l’importanza dei link sulla base del voto di PageRank espresso dalla pagina che contiene il sito web. Un semplice esempio: un link contenuto in una pagina con PR 8 sarà molto più determinante di un medesimo link contenuto in un’altra pagina con PR 4 e avrà un peso nettamente superiore nell’innalzamento del rank del sito “linkato”.

Dove:

PR[A] è la pagina di cui vogliamo calcolare il PageRank.

PR[PK] sono i PageRank delle pagine contenenti i link.

P[K] sono le pagine contenenti i link a PR[A].

C[PK] numero complessivo di link relativi a P[K].

n è il numero di pagine contenenti i link.

d è una costante impostata da Google, valore tipico 0,85.

Google, come gli altri motori di ricerca, è in grado di leggere in maniera metodica i contenuti di una pagina Web e a decretarne il posizionamento iniziale. Questo è reso possibile grazie all’indicizzazione da parte del motore di ricerca, ovvero una scansione automatizzata dei campi che popolano il database del sito. Questa lettura può essere facilitata e ottimizzata scrivendo due file ad hoc destinati allo spider di Google ovvero robots.txt, che sarà discusso in dettaglio nel prossimo paragrafo e Sitemap XML. Quest’ultimo file, come si può notare dall’estensione, è strutturato come XML (eXtendable Markup Language); ciò permette di organizzare dati e contenuti attraverso un “metalinguaggio” comprensibile ai motori di ricerca. La Sitemap contiene l’elenco delle pagine del sito Web, nonché informazioni circa i contenuti e gli indirizzi URL (ovvero puntatori univoci a contenuti sul Web) presenti, con lo scopo d’informare i motori di ricerca circa la loro pubblicazione in rete; infatti non sempre la scansione automatica di Google individua i contenuti appena messi in rete, specie se il sito ha un basso numero di link in entrata. La creazione di questo documento si rivela anche particolarmente utile quando le pagine Web presentano contenuti dinamici, ovvero basate su uno o più database e su una forte interazione sito/utente, poiché permette di evidenziare in maniera semplice ed efficiente i link a questi contenuti. L’uso della Sitemap.XML è quindi vantaggiosa ai fini del SEO e viene sempre valutata positivamente dai motori di ricerca in quanto vi sono anche contenute informazioni aggiuntive, come la data di ultima modifica del documento, la frequenza di aggiornamento e la priorità data a ciascuna pagina. Oggigiorno esistono numerosi tool e plug-in che consentono di automatizzarne la scrittura che di fatto consentono di automatizzare la creazione e l’aggiornamento della Sitemap XML del sito web.

Il crawler di Google: Googlebot

Lo strumento che qualsiasi motore di ricerca impiega per scansionare le nuove pagine pubblicate sul Web (e quindi fare SEO), o per verificare i cambiamenti occorsi a pagine che da più tempo si trovano in rete, prende il nome di crawler o, come è più facile sentir dire, spider Web o robot. Ogni motore di ricerca ne gestisce uno: “Romilda” è quello utilizzato da Facebook, “Scooter” è impiegato da AltaVista, “Slurp” è utilizzato da Yahoo, mentre Google usa “Googlebot“. Lo spider altro non è che un bot, ovvero un programma che in maniera automatizzata va ad analizzare gli URL segnalati dal motore di ricerca, con il fine di scovare collegamenti ipertestuali da aggiungere alla lista di URL da visitare. Googlebot effettua due diversi tipi di scansione: Deep-crawl (scansione in profondità) e Fresh-crawl (scansione recente); la prima viene compiuta una volta al mese circa con l’intento di scansionare l’intero Web ed aggiornare gli indici di Google, il PageRank dei siti e la cache per l’accesso rapido alle pagine Web. Diversamente dalla Deep-crawl, la Fresh-crawl è una scansione eseguita quotidianamente ed ha come scopo quello di tenere costantemente aggiornati gli indici di Google.

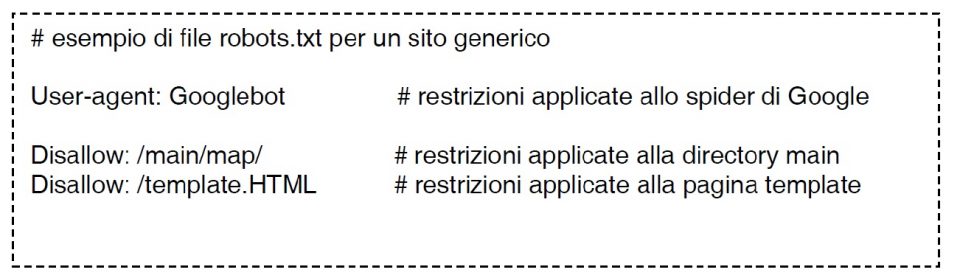

Esistono diverse tecniche per impedire a Googlebot di indicizzare certi tipi di contenuti che non si vuole siano soggetti a scansione; il primo metodo consiste nel creare, manualmente o in modo automatico, un file di testo chiamato robots.txt; questo file di testo contiene informazioni circa i contenuti (directory) che i crawler non possono, o meglio non potrebbero, scansionare per l’indicizzazione. Il fatto che i crawler non siano obbligati a seguire le indicazioni contenuti nel file robots.txt dipende se sono associati o meno al Robots Exclusion Standard, ovvero un protocollo internazionale che sancisce un insieme di regole, cui sono soggetti tutti gli spider che vi hanno aderito.

La sintassi da impiegare per porre questi limiti e vincoli all’interno del file è semplice: il campo user-agent deve essere associato al nome specifico dello spider a cui applicare le restrizioni (come ad esempio Googlebot), mentre il campo disallow contiene uno o più URL di cui si richiede l’esclusione dal processo d’indicizzazione. Inserire un asterisco nel campo user-agent sta a significare che le restrizioni sono applicate a tutti i robot.

Oltre all’utilizzo del suddetto file esiste un altro metodo che permette d’imporre vincoli ai crawler: l’uso del meta tag “robots”. Un meta tag altro non è che un particolare tag HTML che consente di specificare informazioni che saranno lette dai crawler; questi dati hanno una sintassi molto semplice: name, indica il tipo d’informazione, content il valore del contenuto. Il meta tag “robots” può fornire diversi suggerimenti: index suggerisce ai crawler di indicizzare la pagina, noindex si usa per richiedere che il contenuto della pagina non sia indicizzato; esistono altri valori che il campo “content” può assumere, ovvero follow e nofollow: il primo serve a comunicare allo spider di prendere in considerazione tutti i link della pagina, il secondo è una richiesta di non seguire i link della pagina. Queste direttive sono comuni a tutti i motori di ricerca e possono essere combinate fra loro, stando attenti a non generare incompatibilità.

Nel caso specifico di Googlebot esistono due ulteriori comandi, noarchive e nosnippet, in cui si richiede a Google di non memorizzare una copia in cache della pagina Web (noarchive) e di non mostrare la descrizione della pagina nei risultati di ricerca (nosnippet). Il fatto di voler usare la direttiva “noarchive” dipende dalla velocità con cui i contenuti della pagina Web sono aggiornati; editoriali e blog mutano i contenuti di continuo, quindi se si permettesse a Google di mantenere in cache una pagina, sarà molto probabile che la stessa non sia stata aggiornata.

Una variante dell’utilizzo del metatag “nofollow” consiste nel suo utilizzo all’interno delle ancore HTML <a></a> (utilizzate per definire un collegamento ipertestuale) come parametro dell’attributo “ref”; in questo caso s’invitano i crawler a non seguire il link su cui è posta questa direttiva. Usare questo espediente può rivelarsi utile nella gestione di blog o editoriali, in cui si è quotidianamente esposti a messaggi contenenti link di spam. Assegnando l’attributo ref=”nofollow” ai link sospetti si fa in modo che lo spider non vada ad archiviare i link contrassegnati, in modo tale da evitare sanzioni che potrebbero incidere sul PageRank del sito.

Grazie per i tuoi articoli, sono davvero molto utili !!!!!

Grazie, mi fa molto piacere sapere che i miei articoli siano molto utili. Alla prossima.