Evoluzione e nuove applicazioni dei sistemi informatici

I sistemi centralizzati sono nati con l’informatica moderna negli anni ’50 e si sono sviluppati negli anni ’60 e ’70 grazie all’affermarsi delle tecnologie dei mainframe, dei sistemi operativi time-sharing, dei file system e dei DBMS centralizzati (gerarchici e reticolari). La nascita e lo sviluppo, negli anni ’70 e ’80, di nuove tecnologie più economiche, versatili e facili da usare (mini e micro elaboratori, LAN, DBMS relazionali, architetture client-server, interfacce GUI) ha portato alla crisi del modello centralizzato, evidenziandone la minore economicità e qualità del servizio, e ha promosso la realizzazione di sistemi distribuiti in realtà grandi, medie e piccole, dando luogo al fenomeno dell’ “informatica diffusa” a livello mondiale”.

Questo fenomeno di decentralizzazione ha avuto grande impulso per via dei seguenti motivi principali:

- crollo dei prezzi degli apparati hardware e delle relative licenze software;

- maggiore scalabilità, continuità e qualità del servizio da parte dei sistemi distribuiti rispetto a quelli centralizzati;

- maggiore capacità, da parte dei sistemi distribuiti, di venire incontro alle esigenze di flessibilità e di autonomia delle moderne

I sistemi distribuiti implicano scelte gestionali differenti da quelle dei sistemi centralizzati tradizionali. In questi, tipicamente omogenei, il controllo del sistema operativo e della comunicazione terminali/host richiede un staff di analisti/sistemisti dedicato, che sia in grado di assicurare il regolare funzionamento operativo del sistema, e la manutenzione e la gestione di configurazione del sistema sono perfettamente definiti, in quanto vengono svolti in modo centralizzato.

Con l’avvento dei sistemi distribuiti nasce la possibilità di scegliere e combinare, ai vari livelli dell’architettura, componenti provenienti da fornitori diversi. La definizione del sistema richiede la risoluzione di un insieme di problemi, quali la scelta della piattaforma per il client, di quella per il server (che in generale è differente) e dei protocolli di comunicazione. A fronte della maggior complessità nella definizione e gestione del sistema, causata principalmente dall’eterogeneità, si ottenengono in cambio vantaggi dovuti alla possibilità di scegliere per ogni componente quanto di meglio (in termini economici e/o qualitativi) offre il mercato.

Nei primi anni ’90, sulla base dell’esperienza maturata nella gestione dell’informatica diffusa, il modello distribuito è stato sottoposto a forte critica proprio per la maggiore complessità progettuale, che determina in generale maggiori costi realizzativi e minore robustezza delle realizzazioni e per la maggiore complessità gestionale, che genera costi spesso nascosti per gli utenti e le organizzazioni.

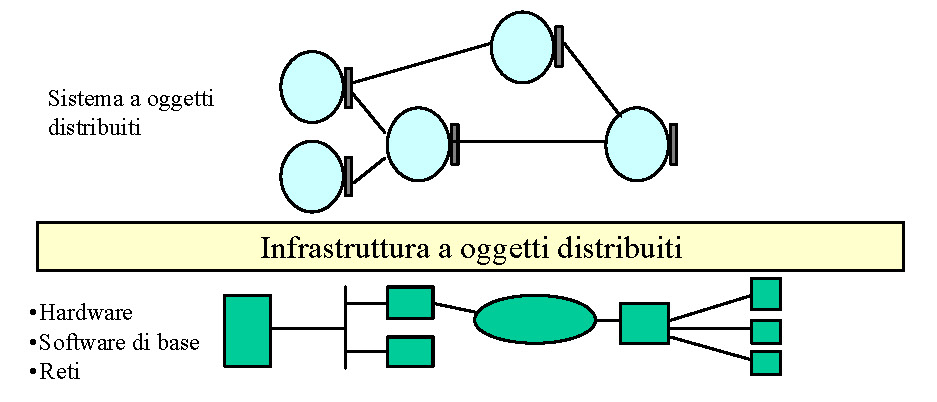

L’analisi critica dei punti di forza e dei punti di debolezza del modello centralizzato e del modello distribuito ha portato la comunità scientifica ed i fornitori di tecnologie ad elaborare un nuovo modello di elaborazione, il Distributed Object Computing (D.O.C. o DOC), che tende a fornire un contesto virtualmente unitario di elaborazione, in cui più processi elaborativi (oggetti) cooperano come se risiedessero su un’unica macchina, si veda la figura seguente.