Differenza tra bit e byte in informatica

In informatica, bit e byte sono unità di memoria del computer. La principale differenza tra bit e byte è che un bit è l’ unità più piccola della memoria del computer, che ha la capacità di memorizzare un massimo di due valori diversi mentre un byte, composto da 8 bit, può contenere 256 valori diversi .

Cos’è un bit

I computer sono dispositivi elettronici e funzionano solo con valori discreti. Quindi, alla fine, qualsiasi tipo di dati che il computer vuole gestire viene convertito in numeri. Tuttavia, i computer non rappresentano i numeri nello stesso modo in cui lo facciamo noi umani. Per rappresentare i numeri, usiamo il sistema decimale che fa uso di 10 cifre (0, 1, 2, 3, 4, 5, 6, 7, 8, 9). Per rappresentare i numeri, i computer moderni utilizzano un sistema binario composto da due cifre (0 e 1). “Bit” è il nome dato alla più piccola unità di dati che può essere rappresentata con questo sistema ( Bit sta per “cifra binaria”). cioè, in termini di numeri binari, un po ‘consiste di uno 0 o di un 1. Nell’elettronica che compone il computer, un bit può essere rappresentato dall’avere due tensioni. Uno stato “off” (0 volt) potrebbe rappresentare uno 0 binario e uno stato “on” (con una tensione massima) potrebbe rappresentare un 1 binario.

Nel sistema binario, qualsiasi numero può essere rappresentato utilizzando 0 e 1 sebbene il binario richieda più cifre per rappresentare un numero rispetto al decimale (ad esempio, il numero decimale 123 è rappresentato in binario come 1111011). Per esprimere dati complessi, sono necessari numeri più grandi e quindi più bit. Ad esempio, un colore può essere descritto da quanto rosso, verde e blu compongono quel colore. Nel sistema che utilizziamo, ogni valore per rosso, verde o blu potrebbe richiedere fino a 256 valori (0-255). Usando binario, quindi, per rappresentare ogni valore rosso, blu o verde occorrono 8 bit (perché 28=256). Quindi, per rappresentare un colore, occorrono 24 bit in totale.

Nel campo emergente dell’informatica quantistica, la più piccola unità di dati che può essere rappresentata è un qubit . In contrasto con i nostri “bit tradizionali”, i qubit fanno uso di fenomeni di meccanica quantistica in modo che ogni “bit” sia in grado di rappresentare non solo due, ma diversi valori possibili. L’informatica quantistica è ancora agli inizi, tuttavia, una volta completamente sviluppati, i computer quantistici saranno molto più potenti dei computer che abbiamo oggi.

Cos’è un Byte

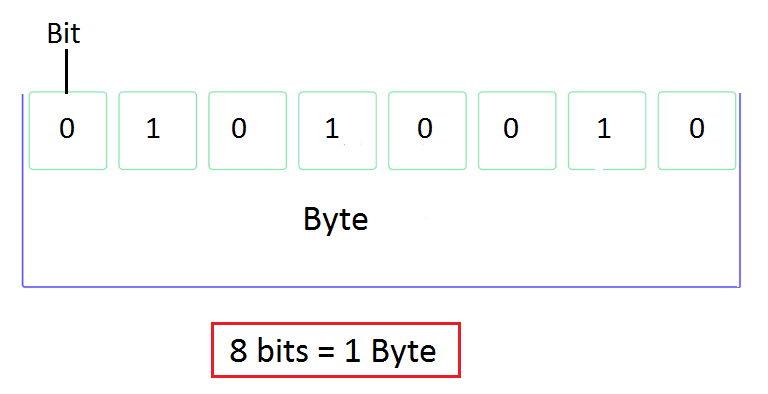

Un byte è un’unità di dati composta da 8 bit. Utilizzando un byte, si potrebbero rappresentare 28=256 valori diversi. Ad esempio, in Java, il tipo di dati byteviene utilizzato per rappresentare un numero compreso tra -128 e 127. In C / C ++, anche il tipo di dati charè composto da 8 bit. In C / C ++, charviene utilizzato per memorizzare un singolo carattere. In molte architetture di computer, un byte è la più piccola unità di memoria indirizzabile. Tradizionalmente, un singolo era stato rappresentato utilizzando 1 byte. Con il sistema di codifica ASCII originale, sono necessari solo 7 bit per rappresentare un carattere, quindi l’ultimo bit sarebbe sempre 0 (per “ultimo”, intendo il più a sinistrabit quando il numero è scritto come binario). Ad esempio, il carattere “B” è rappresentato utilizzando 01000010 e il carattere “b” utilizzando 01100010. Le persone che avevano bisogno di utilizzare caratteri che non sono in ASCII standard hanno sfruttato il bit inutilizzato per formare i propri sistemi di codifica ASCII estesa . Al giorno d’oggi, la codifica Unicode è teoricamente in grado di rappresentare più di un milione di caratteri diversi.

I file tipici di solito hanno dimensioni dell’ordine di kilo o megabyte. In questo caso, un kilobyte (KB) è costituito da 1024 byte e un megabyte (MB) da 1024 kilobyte . Rispetto alla tradizionale nomenclatura SI, dove i prefissi successivamente più grandi sono definiti in termini di multipli di 1000, i computer usano multipli di 1024 perché è più naturale in termini di sistema numerico binario, 1024 essendo 2 10 (100000000 in binario).

Differenza tra un bit e un byte

Dimensioni dell’unità

Un bit è la più piccola unità di dati che può essere rappresentata nei computer.

Un byte è composto da 8 bit.

Valori

Utilizzando un bit, è possibile rappresentare un massimo di 2 valori.

Un byte può rappresentare 256 valori diversi.

In molte architetture di computer, un byte costituisce la più piccola unità di memoria indirizzabile. In questi sistemi, la dimensione minima che una variabile può contenere è 1 byte.